- ▶ Management de l'entreprise ▶ Management Démocratique

- Conception de la stratégie

- Principes de gouvernance

- La Performance des métier

- Le contrôle de gestion

- ▶ Innover en équipe

- L'Innovation et la Performance

- L'Innovation Managériale

- La Méthode SOCRIDE

- ▶ Décider au quotidien

- Le processus de Décision

- La Décision en équipe

- Les Techniques de décision

- ▶ Guide gratuit de l'Autoformation

- Méthode d'autoformation

- Les 7 Qualités pour réussir

- Comment s'auto-évaluer ?

- ▶ Formation Gratuite Management

- Formation tableau de bord et BI

- Formation Management de Projet

- Formation Entrepreneuriat

- ▶ ebook et PDF management gratuits

- ▶ PDF Entrepreneuriat

- ▶ ebook Perfonomique

Data Warehouse, Entrepôt de Données

- Définition du Data Warehouse

- Principales caractéristiques

- Architecture technique du Data Warehouse

- Origine du DW

- Versus Big Data

- Tuto: La business Intelligence et la méthode Gimsi

- Ressources sur le même thème

Qu'est-ce qu'un Data Warehouse ?

Définition

Le Data Warehouse, ou entrepôt de données, est une base de données dédiée au stockage de l'ensemble des données utilisées dans le cadre de la prise de décision et de l'analyse décisionnelle.

Le Data Warehouse, ou entrepôt de données, est une base de données dédiée au stockage de l'ensemble des données utilisées dans le cadre de la prise de décision et de l'analyse décisionnelle.

Le Data Warehouse est exclusivement réservé à cet usage. Il est alimenté en données depuis les bases de production grâce notamment aux outils d'ETL Extract Transform Load.

Les utilisateurs, analystes et décideurs accèdent ensuite aux données collectées et mises en forme pour étudier des cas précis de réflexion. Ils construisent des modèles d'étude et de prospective pour limiter la part d'incertitude lors du processus de prise de décision.

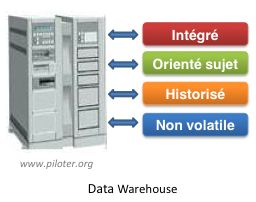

Caractéristiques du Data Warehouse

Le Data Warehouse n'est pas une simple copie des données de production. Le data warehouse est organisé et structuré.Père du concept, Bill Immon dans son livre "Building the Data Warehouse" (John Wiley and Son 1996) le décrit ainsi :

Subject oriented, integrated, nonvolatile, time variant collection of data in support of management decisions.

Les 4 caractéristiques du Data Warehouse

-

Orienté sujet

Au coeur du Data warehouse, les données sont organisées par thème.

Les données propres à un thème, les ventes par exemple, seront rapatriées des différentes bases OLTP de production et regroupées. -

Intégré

Les données proviennent de sources hétérogènes utilisant chacune un type de format.

Elles sont intégrées avant d'être proposées à l'utilisation. -

Non volatile

Les données ne disparaissent pas et ne changent pas au fil des traitements, au fil du temps (Read-Only). -

Historisé

Les données non volatiles sont aussi horodatées. On peut ainsi visualiser l'évolution dans le temps d'une valeur donnée.

Le degré de détail de l'archivage est bien entendu relatif à la nature des données.

Toutes les données ne méritent pas d'être archivées.

Data Warehouse Open Source

- Infobright , le moteur Data Warehouse pour mySQL

- Voir ici le projet Data Warehouse Open Source

Architecture technique du Data Warehouse

3 architectures technologiques typiques et classiques pour le stockage de grandes quantités de données pour des fins décisionnelles : SMP, MMP et Cluster.1. SMP (Symetric Multi-Processing)

Principe

Le modèle d'architecture de type "SMP" est fondé sur l'exploitation de plusieurs processeurs identiques oeuvrant en parallèle et partageant une mémoire commune.Inconvénients

La mémoire est unique, la synchronisation de l'accès à la mémoire par les différents processeurs constitue le principal inconvénient de ce type d'architecture.

2. MMP (Massively Parallel Processing)

Principe

Le modèle d'architecture de type "MPP" est fondé sur l'exploitation d'un nombre important de processeurs. Chaque processeur dispose de sa propre mémoire.Inconvénient

Il nécessite des développements spécifiques. Les traitements doivent être prévus dès la conception pour une exécution sur ce type d'architecture.

3. Cluster

Principe

Avec l'architecture de type "Cluster", les ordinateurs sont organisés en "grappes". Ils sont interconnectés par des liaisons rapides Ethernet. Sur le plan du principe, le fonctionnement est assez proche de l'architecture MMP.

Inconvénient

Le programme à exécuter doit impérativement être développé pour ce type d'architecture.

Data warehouse de nouvelle génération

- Les solutions autour du moteur Hadoop de Apache Fundation

- Les principes du Cloud Computing pour l'entreprise

- Les principes d'IaaS

Attention au sous-dimensionnement, et n'hésitez pas à jeter un oeil sur les réalisations de la concurrence.

Quelques constructeurs

- NCR Teradata, un site constructeur mais disposant de pas mal d'infos

- IBM DB2, le système de Data Warehouse d'IBM

- Autonomous Data Warehouse, le système de Data Warehouse d'Oracle sur le "Cloud"

- Oracle, La nouvelle génération d'Oracle Autonomous Data Warehouse est disponible

L'Infocentre, l'ancêtre des bases de données décisionnelles

L'infocentre était un SGBDR présentant une copie de travail d’une partie de la base de production mise à jour périodiquement.L'infocentre était une première solution pour soulager le système de production des requêtes complexes du décideur. Il permettait en effet de transférer les données de base de type non relationnel dans un univers plus propice à l’interrogation impromptue.

Avec l’accroissement des besoins en matière de décision, que ce soit en termes de quantité de données collectées ou en nombre d’utilisateurs potentiels, l'infocentre se révéla bien insuffisant. Le DW l’a rapidement remplacé.

Un projet de Management

Pour Bill Inmon, père "putatif" du Data Warehouse et auteur de l'ouvrage Building the Data Warehouse, la finalité n'est pas de fédérer l'ensemble des données de production.Le datamart n'est pas non plus un entrepôt de taille réduite qui attend patiemment de grandir... La finalité est tout autre.

Toutes les entreprises ne passeront pas au Big Data...

Cela dit Big Data ou pas , c'est bien le soin avec lequel on a structuré la base qui assure de la qualité des informations décisionnelles que l'on pourra en extraire.S'extasier devant la capacité de stockage des bases en pleine croissance exponentielle est devenu un vrai poncif. Cela dit, les chiffres sont de plus en plus impressionnants.

Considérons une base typique comme Microsoft Azure SQL qui propose une capacité maximale de 240 Teraoctets (1012). Un livre texte de 300 pages occupant environ 900.000 octets (300*3.000), on pourrait donc stocker sur cette base l'équivalent de 200 Téraoctets/900000, c'est-à-dire environ 200 millions d'ouvrages...

Soit bien plus que les 14 millions de livres de la BNF (1).

C'est un exemple à ne pas prendre à la lettre, il s'agit juste de donner une idée concrète de ces dimensions tout en sachant que les bases les plus importantes utilisent le pétaoctet (1015) comme unité de mesure.

Il est bien évident qu'en situation de décision, il ne s'agit pas de chercher à accéder à une telle masse de données. Chaque décideur désire l'accès uniquement à celles qui l'intéresse bien entendu.C'est bien par la question de la structure de la base qu'il faut commencer, lui donner du sens pour en extraire des enseignements pertinents.

De toute façon, toutes les entreprises ne sont pas prêtes à passer au Big data (voir ici le dossier big data). Le Big Data exige un investissement conséquent, non seulement dans la technologie mais aussi dans la compétence. Sans un spécialiste de l'analyse et des managers bien sensibilisés donc bien formés, la technologie a elle seule ne sert pas à grand chose...

Revenons à la question du Data Warehouse plus classique :- 1. À quelles informations veut-on pouvoir accéder ?

- 2. Quelles données faut-il alors mettre dans le DW ?

- 3. Comment doit-on les organiser ?

À noter, une question subsidiaire d'importance avant de dimensionner définitivement le système : Et demain ? On évolue comment ?

Facteurs d'utilité et de performance du système

La qualité de l'intégration des données au sein du Data Warehouse est désormais reconnue comme le principal facteur conditionnant la réussite du système décisionnel. C'est dire si cet aspect du projet Business Intelligence mérite un soin particulier.Il ne faudrait pas pour autant que ce point, quoique essentiel, mobilise la totalité des efforts de conception. L'ensemble du projet est complexe. Il serait ainsi peu judicieux de ne pas consacrer autant d'attention à l'épineuse question de l'organisation des bases décisionnelles.

L'hypothétique information...

Ce second aspect influence directement la facilité d'accès à une information précise. En effet, l'utilisateur en situation ne dispose jamais du temps et de l'énergie nécessaires pour fouiller dans les bases en quête d'une hypothétique information.L'accessibilité en un temps raisonnable à l'information traduit en fait le degré d'utilité (et aussi d'utilisation) du système décisionnel.

Pour faire simple, plus les informations seront faciles d'accès, plus l'instrument sera utilisé et par conséquent, plus il sera appelé à se développer. Éternelle règle de l'utilité et de l'utilisation des systèmes informatiques.

Bref, il sagit là ni plus ni moins du facteur définissant la performance globale du système d'aide à la décision.

Tuto: Business Intelligence et méthode Gimsi

Formation gratuite à la conception du projet Business Intelligence centré tableau de bord. deuxième partie de la méthode GImsi, 3ème partie. Cette formation est une initiation, une introduction à l'ouvrage de référence : Les nouveaux tableaux de bord des managers : -

Instaurer la démocratie dans l'entreprise

Instaurer la démocratie dans l'entreprisePour en finir avec le mépris, principe délétère du management d'hier et d'aujourd'hui

Auteur : Alain Fernandez

Sujet : Expérience concrète d'instauration de la démocratie au sein d'une PME

Pages : 360 pages

Prix Format papier : 19,95 €

Prix Format ebook : 9,99 € (epub ou kindle) Librairies en ligne...

Dispo :

![]() Présentation détaillée du livre "la transformation démocratique de l'entreprise"

Présentation détaillée du livre "la transformation démocratique de l'entreprise"

L’auteur

Alain Fernandez est un spécialiste de la mesure de la performance, de l’aide à la décision et de la conception de tableaux de bord de pilotage. Au fil de ces vingt dernières années, il a conduit de nombreux projets de réalisation de système décisionnel en France et à l'International. Il est l'auteur de plusieurs livres publiés aux Éditions Eyrolles consacrés à ce thème, vendus à plusieurs dizaines de milliers d'exemplaires et régulièrement réédités.

Alain Fernandez est un spécialiste de la mesure de la performance, de l’aide à la décision et de la conception de tableaux de bord de pilotage. Au fil de ces vingt dernières années, il a conduit de nombreux projets de réalisation de système décisionnel en France et à l'International. Il est l'auteur de plusieurs livres publiés aux Éditions Eyrolles consacrés à ce thème, vendus à plusieurs dizaines de milliers d'exemplaires et régulièrement réédités. Ressources web

Ressources web

- Vous ne perdrez pas votre temps en vous attardant sur les travaux de Ralf Kimball, expert Data Warehouse

- Quelle approche choisir, celle de Inmon ou celle de Kimball ?

- Un article du Monde Informatique Oracle simplifie son datawarehouse autonome pour les métiers

- Un article sur le portail de Silicon.fr Le Data Warehouse fait sa révolution digitale

- Un article sur le portail LeMagIT Bien choisir son Data Warehouse nouvelle génération

À ce sujet, voir aussi

À ce sujet, voir aussi

Modélisation du data warehouse, schéma en étoile

Modélisation du data warehouse, schéma en étoile

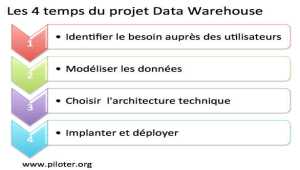

Commençons par un rappel sur la modélisation des bases de données en utilisant le schéma en étoile, et intéressons-nous ensuite aux spécificités de la Business Intelligence... Le projet Data Warehouse, un processus continu

Le projet Data Warehouse, un processus continu

Voyons les 4 étapes du projet DW qui sera toujours en perpétuelle évolution, et où il est essentiel de se placer sous l'angle de l'utilisateur et non sous celui de la technique. Le ROI de la Business Intelligence

Le ROI de la Business Intelligence

Le projet Business Intelligence est un projet d'envergure. Et comme pour tout projet d'envergure, il faut apporter un soin tout particulier au calcul du ROI. DataMart l'entrepôt de données sectoriel

DataMart l'entrepôt de données sectoriel

Le Data Mart, ou DataMart, peut être défini comme la version allégée du Data Warehouse...

À lire...

À lire...

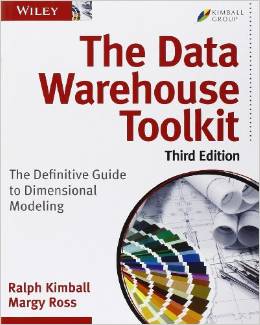

L'ouvrage de référence du projet Data Warehouse.

Véritable "guide de terrain" alimenté par les 25 années d'expertise de Ralph Kimball dans le domaine du data warehouse, cet ouvrage met à la disposition des décideurs tout un ensemble d'outils et de techniques pour concevoir, développer et déployer un data warehouse au sein d'une grande entreprise.

Ralph Kimball, Margy Ross sont des experts très largement reconnus. L'approche pratique et très terrain dont ils sont coutumiers se retrouve à chacun des chapitres de cet ouvrage particulièrement complet...

The Data Warehouse Lifecycle Toolkit

The Data Warehouse Lifecycle Toolkit

R. Kimball, M. Ross, W. Thornthwaite, J. Mundy, B. Becker

John Wiley & Sons Ltd

3ème édition

600 pages (anglais)

The Data Warehouse Toolkit Classics : Version en coffret de 3 volumes...

The Data Warehouse Toolkit Classics

The Data Warehouse Toolkit Classics

R. Kimball, M. Ross, W. Thornthwaite, J. Mundy, B. Becker, J. Caserta

John Wiley & Sons Ltd

2ème édition

1800 pages (anglais)

Livre de référence du site. Guide de réalisation du système de business Intelligence de l'entreprise orienté besoins des utilisateurs pour une prise de décision efficace. Attention, il s'agit d'un ouvrage nettement moins technique que les précédents. Référence francophone du management de la performance...

Les nouveaux tableaux de bord des managers

Les nouveaux tableaux de bord des managers

Le projet Business Intelligence clés en main

Alain Fernandez

6ème édition Eyrolles

468 pages

Pour acheter ce livre :

Format ebook : PDF ou ePub, Kindle

Piloter l'Entreprise Innovante...

Piloter l'Entreprise Innovante...

Avez-vous déjà essayé d'instaurer la prise de décision en équipe ? Sans précautions préalables, rapidement, le consensus le plus mou qui soit vient casser les plus pures ambitions. Mais connaissez-vous la méthode SOCRIDE centrée sur les questions incontournables de Confiance et de Reconnaissance ? Rien de plus facile ! Elle est expliquée, illustrée et détaillée dans ce livre :

Les tableaux de bord du manager innovant

Les tableaux de bord du manager innovant

Une démarche en 7 étapes pour faciliter la prise de décision en équipe

Alain Fernandez

Éditeur : Eyrolles

Pages : 320 pages

![]() Consultez la fiche technique »»»

Consultez la fiche technique »»»

Pour acheter ce livre :

Format ebook : PDF & ePub,

Format Kindle

Voir aussi...

Partagez cet article...

Partagez cet article...

(total partages cumulés > 65)

Ouvrages du même auteur

Réformer le management

Décider en équipe

Tableau de bord DIY

Bonnes pratiques projet

Le système décisionnel

De salarié à entrepreneur

Astuces Entrepreneur